Evil-GPT: O “Inimigo do ChatGPT”

Na paisagem em constante evolução do cibercrime, uma ferramenta surgiu como um interveniente particularmente insidioso: o Evil-GPT. Comercializado em fóruns de hackers na dark web como o "inimigo definitivo do ChatGPT" e a "melhor alternativa ao WormGPT", este chatbot de IA malicioso rapidamente ganhou notoriedade entre os criminosos cibernéticos. O Evil-GPT foi concebido para ajudar atacantes a executar uma série de atividades nefastas, desde a criação de malware até à geração de ataques de phishing.

A publicação na dark web mostrada abaixo promove o Evil-GPT como um chatbot construído em Python por apenas $10. O exemplo de prompt no anúncio pede um malware em Python que rouba as credenciais de um utilizador e cookies do navegador, e depois os exfiltra através de um webhook do Discord — exatamente o tipo de tarefa que a ética do ChatGPT bloquearia.

Funcionalidades do Evil-GPT

Evil-GPT é essencialmente um assistente de código de IA não censurado, especializado em produzir saídas maliciosas sem os filtros de segurança típicos encontrados em modelos de IA legítimos. De acordo com análises de cibersegurança, pode gerar scripts de malware (para roubo de dados, recolha de informações do sistema, etc.) e criar iscas de phishing, tudo sem filtros de segurança. Por exemplo, num caso documentado, Evil-GPT produziu um script em Python para capturar cookies do Chrome e dados do sistema e enviá-los para o servidor de um atacante. Esta funcionalidade posiciona Evil-GPT como uma "fábrica de malware" barata, particularmente atraente para hackers com poucas competências.

Notavelmente, o Evil-GPT foi supostamente construído inteiramente em Python e foi comercializado como uma alternativa leve a modelos de IA mais intensivos em recursos. O seu design foca-se na furtividade e roubo — por exemplo, roubar dados do navegador ou credenciais — sugerindo que é destinado a auxiliar no roubo de informações, desenvolvimento de Trojan de acesso remoto (RAT) e outras tarefas de malware agentico.

Promoção e branding

Evil-GPT surgiu pela primeira vez em agosto de 2023 no popular fórum da dark web BreachForums. O vendedor, usando o pseudónimo "AMLO", posicionou-o explicitamente como "a melhor alternativa ao WormGPT" para aspirantes a hackers. Ao rotulá-lo como o "inimigo do ChatGPT", o vendedor destacou a sua ausência de restrições em comparação com ferramentas de IA mais convencionais. O preço baixo (apenas $10 por cópia) e o anúncio no fórum público indicam uma estratégia para comercializar em massa esta ferramenta para cibercriminosos à procura de assistência de IA acessível.

A empresa de inteligência de ameaças FalconFeeds até capturou capturas de ecrã do fórum e notou que o vendedor apenas se tinha juntado a esse fórum em agosto de 2023, o que implica que o Evil-GPT era um produto recém-lançado na altura. Ao contrário de algumas ferramentas de IA baseadas em subscrição mais caras, o modelo de venda única e o baixo custo do Evil-GPT sugerem que estava destinado a uma adoção generalizada (ou potencialmente a um rápido ganho financeiro por parte do vendedor).

Utilização e atualizações reais

Quanto o Evil-GPT tem sido utilizado em ataques reais é uma questão em aberto. No final de 2023, investigadores alertaram que o Evil-GPT poderia baixar a fasquia para a geração de malware e phishing em larga escala. Uma investigação da Trend Micro descobriu que o Evil-GPT pode não ser sequer um modelo de IA totalmente independente — parecia funcionar como um invólucro em torno da API do OpenAI, exigindo uma chave de API para operar. Em outras palavras, o Evil-GPT pode ter estado a invocar o ChatGPT "nos bastidores" com engenharia de prompts inteligente para contornar os filtros da OpenAI.

Esta descoberta sugere que alguns kits de ferramentas criminosos são mais exagero do que realidade, essencialmente reembalando IA legítima de forma maliciosa. No entanto, mesmo um simples invólucro pode ser valioso para atores maliciosos se proporcionar anonimato (usando chaves de API roubadas) e uma biblioteca de instruções de jailbreak funcionais.

Até 2024, as redações em relatórios de segurança e artigos de notícias continuaram a citar o Evil-GPT como parte do crescente conjunto de ferramentas de IA maliciosas. O seu reconhecimento de nome na comunidade subterrânea indica que, pelo menos, o Evil-GPT conseguiu entrar no discurso como uma ferramenta de crimeware viável.

As empresas devem assumir que e-mails de phishing ou código malicioso que encontram podem ter sido gerados automaticamente por ferramentas como a Evil-GPT, dada a acessibilidade que esta se tornou. O baixo custo e a disponibilidade pública significam que os respondedores a incidentes podem encontrar cada vez mais as impressões digitais da Evil-GPT (ou de IA semelhantes) em investigações de cibercrime no futuro.

Conclusão

Evil-GPT exemplifica o potencial sombrio da IA generativa quando colocada nas mãos de criminosos cibernéticos. À medida que continuamos esta série, exploraremos outras ferramentas de IA maliciosas, incluindo WolfGPT, DarkBard e PoisonGPT, cada uma contribuindo para o cenário de ameaças em evolução. Compreender estas ferramentas e as suas implicações é crucial para as organizações que procuram reforçar as suas defesas contra a crescente onda de cibercrime impulsionada pela IA. Fique atento ao nosso próximo post, onde iremos explorar WolfGPT e as suas capacidades como uma IA sombria melhorada para a criação de malware.

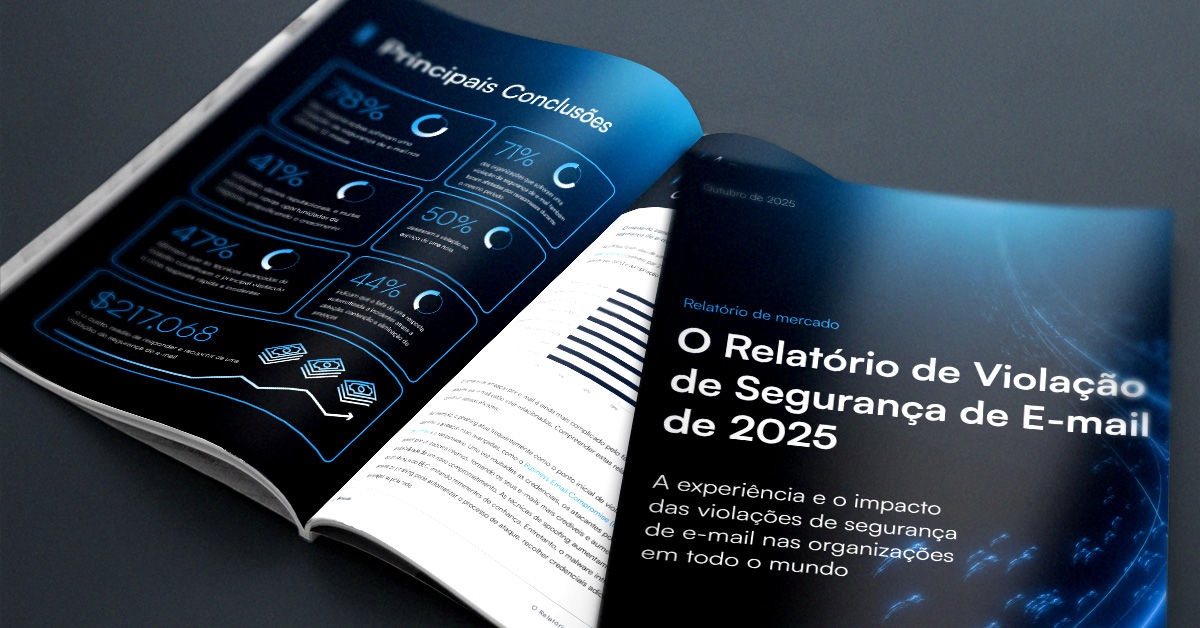

O Relatório de Invasão de Segurança de E-mail de 2025

Principais conclusões sobre a experiência e o impacto das violações de segurança de e-mail em organizações em todo o mundo

Subscreva o Blogue Barracuda.

Inscreva-se para receber destaques sobre ameaças, comentários do setor e muito mais.

Relatório de Insights do Cliente MSP 2025

Uma visão global sobre o que as organizações precisam e desejam dos seus provedores de serviços geridos de cibersegurança